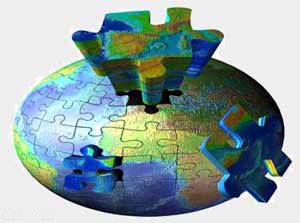

El Año Internacional del Planeta Tierra (AIPT) ha impulsado la creación del primer mapa geológico global en formato digital, accesible desde Internet. Se trata del proyecto OneGeology, y en su elaboración está participando activamente el Instituto Geológico y Minero de España (IGME).

Éste fue uno de los aspectos más destacados ayer en una jornada científica celebrada en el Ateneo de Madrid para hacer balance del AIPT, que contó con la participación de un prestigioso elenco de científicos nacionales como José Luis Sanz, catedrático de Paleontología, Juan Luis Arsuaga, codirector del yacimiento de Atapuerca, Jerónimo López, experto en cambio climático o José Manuel Sánchez Ron, catedrático de Historia de la Ciencia, entre otros.

OneGeology, una iniciativa internacional de todos los institutos geológicos del mundo dará lugar a un mapa digital dinámico e interactivo accesible para todos los internautas, creando un punto de encuentro para el acceso a información geológica.

Para el geólogo Simon Winchester, autor del libro 'El mapa que cambió el mundo', "la idea de producir un mapa digital de los tendones y músculos de nuestro planeta vivo, de la estructura, en su mayoría invisible, de la Tierra, sostén de todas las criaturas vivientes, incluyendo la Humanidad, tiene una gran nobleza y una gran elegancia poética. La Historia juzgará de manera positiva a esta década si logramos crear una empresa cartográfica global de esta magnitud y de una visión tal".

José Pedro Calvo, director del Instituto Geológico y Minero y presidente del Comité Español del AIPT destacaba ayer que "la contribución española está siendo muy importante, ya que España dispone de una información muy sólida sobre las características del territorio dado nuestro completo conocimiento cartográfico".

Cooperación internacional

Por su parte, Eduardo de Mulder, el director ejecutivo del AIPT, destacó que "el principal éxito de este proyecto ha sido involucrar muchas naciones en el mundo que han demostrado un interés muy activo. Tenemos más de 75 países que han formado un comité nacional, como es el caso de España, y que en conjunto representan el 80% del total de la población mundial. El resultado ha sido muy significativo".

Las actividades del AIPT, un proyecto bajo el auspicio de la Unesco, se han centrado en 10 áreas: aguas subterráneas, riesgos naturales, Tierra y salud, clima, recursos naturales, megaciudades, tierra profunda, océanos, suelos y Tierra y vida.

"No hemos podido realizar grandes proyectos, sino que hemos animado a proyectos que ya contaban con financiación a que se desarrollasen en la agenda del Año Internacional. OneGeology es nuestro proyecto internacional más importante", explicó De Mulder.

En cuanto a la repercusión inmediata que el AIPT ha tenido dentro de nuestras fronteras, Calvo considera que "ha supuesto un gran impulso para la difusión de las geociencias en nuestro país, ya que al ciudadano le ha llegado una amplia información sobre los 10 bloques temáticos que articulan la celebración y además, se ha producido una gran movilización dentro de la comunidad científica tanto en el ámbito universitario como en los organismos públicos de investigación y de enseñanza primaria y secundaria".

El aspecto educativo del proyecto es algo que Calvo considera prioritario: "Yo diría que es el tema central del Año Internacional del Planeta Tierra a nivel mundial, acercarse a los jóvenes, porque hay muchos problemas relacionados con el planeta que necesitan expertos que en el futuro sepan gestionarlos adecuadamente, y para eso se necesita conocimiento, tanto de carácter científico como tecnológico, y es evidente que ese papel lo tienen que desarrollar las generaciones futuras, nuestros niños y jóvenes".