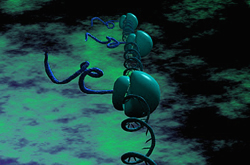

La conciencia humana y su relación con el cerebro ha sido hasta ahora un misterio difícil de resolver. Gracias a un experimento realizado con enfermos de epilepsia que, por su patología, llevaban implantados electrodos en lo más profundo del cráneo, científicos del INSERM de Francia han logrado registrar la actividad cerebral correspondiente a un proceso consciente: la lectura de palabras. Así, han conseguido establecer cuatro marcadores en dicha actividad, que diferenciarían la conciencia de la no-conciencia. Estos resultados podrían, por ejemplo, ayudar a buscar señales de conciencia en personas que sufren daño cerebral pero también despejan las dudas sobre la naturaleza de la conciencia: ésta es dinámica y se distribuye por todo el cerebro, y no se encuentra en un lugar específico de éste.

TENDENCIAS CIENTÍFICAS

La conciencia es una propiedad emergente de la mente humana, pero cuestiones básicas acerca de ella, como sus tiempos, su localización o la dinámica de los procesos neuronales que permiten el acceso consciente a la información que nos rodea, aún no han sido determinadas.

Esta falta de información se ha subsanado en parte gracias al trabajo realizado por un equipo de neurocientíficos (Raphaël Gaillard, Stanislas Dehaene, Lionel Naccache y otros) de la unidad de "Neuroimaginería Cognitiva" del Institut National de la Santé et de la Recherche Médicale (INSERM).

Estos investigadores han demostrado, por vez primera, que el acceso a la conciencia se expresa, en el cerebro, mediante cuatro marcadores diferentes de actividad cerebral, informa el INSERM en un comunicado.

El hallazgo de dichos marcadores fue posible gracias a los electrodos implantados en los cerebros de un grupo de personas con epilepsia, que previamente habían sufrido esta intervención como consecuencia de su enfermedad, y que se prestaron a ayudar a los científicos en su investigación.

Oportunidad de conocer la conciencia

Según explica al respecto la revista New Scientist, las señales de actividad neuronal detectadas y recogidas por los electrodos parecen demostrar que la conciencia es producto de la actividad coordinada de todo el cerebro y que existiría una "marca de conciencia", es decir, un patrón de actividad neuronal correspondiente a la conciencia y que vendría determinado por los cuatro marcadores antes mencionados.

En la revista PLOS Biology, donde se ha publicado el artículo que detalla el experimento, se explica que algunos neurocientíficos han argumentado que la conciencia se encuentra en un solo lugar del cerebro, pero que la idea predominante en la actualidad es que la conciencia sería una propiedad más global.

Pero, hasta el momento, probar cualquiera de estas teorías ha resultado un verdadero desafío, dado que las técnicas no invasivas, como la exploración de resonancia magnética o el electroencefalograma, pueden dar información espacial o temporal, pero no ambas.

La única manera de conseguir ambos datos simultáneamente es implantar electrodos en lo más profundo del cráneo, pero por razones éticas esta operación no puede realizarse con personas sanas. La oportunidad brindada por los enfermos de epilepsia ha abierto la puerta a los científicos.

Experimentando con palabras

En el experimento participaron 10 individuos a los que se habían implantado electrodos intracraneales para tratarlos para un tipo de epilepsia que es resistente a los medicamentos.

Mientras que se registraban las señales recogidas por dichos electrodos, los investigadores fueron proyectando palabras ante los ojos de los participantes, durante tan sólo 29 milisegundos. Estas palabras podían ser amenazadoras (matanza, ira) o emocionalmente neutras (primo, ver).

Los vocablos a veces iban precedidos y seguidos de "máscaras" visuales, que evitaban que las palabras fueran procesadas de manera consciente (percepción subliminal), y otras veces podían verse con claridad, esto es, que las palabras podían ser procesadas conscientemente.

Los participantes debían presionar un botón para indicar la naturaleza de cada vocablo, lo que permitió a los científicos confirmar si habían sido conscientes de él o no.

Cuatro marcadores

En total, los investigadores recibieron información de 176 electrodos, que cubrían casi la totalidad del cerebro de los participantes. Así, pudieron establecer que la conciencia de las palabras percibidas podía asociarse a los siguientes cuatro marcadores.

En primer lugar, durante los primeros 300 milisegundos del experimento, la actividad cerebral fue muy similar tanto durante las tareas conscientes como durante las tareas no inconscientes, lo que indica que el proceso de conciencia tarda más o menos ese tiempo en comenzar.

Inmediatamente después, diversos tipos de actividad cerebral se produjeron (oscilaciones tardías y prolongadas y aumento de la potencia en las frecuencias gamma), pero sólo con aquellas palabras de las que los participantes habían sido conscientes y no con las otras.

También se constató un aumento tardío y prolongado de las oscilaciones simultáneas (sincronías) de dos áreas cerebrales distantes, en las frecuencias beta. Por último, se reveló un aumento tardío y prolongado de la comunicación recíproca entre áreas cerebrales distantes.

Un proceso convergente y dinámico

Dado que estos marcadores sólo se registraron cuando los voluntarios fueron conscientes de las palabras, Gaillard y sus colaboradores señalan que los cuatro supondrían una "marca o patrón de la conciencia".

Tal y como explican los investigadores en el comunicado del INSERM, estos cuatro marcadores, que aparecen 300 milisegundos después de la percepción de una palabra, reflejarían una cooperación cerebral intensa.

Esta convergencia de marcadores caracterizaría el proceso de la conciencia y aportaría una visión más moderna de ésta. En lugar de buscar un sitio específico donde encontrarla, la conciencia deberá ser considerada una dinámica general y distribuida de la actividad cerebral, concluyen los investigadores.

Bernard Baars neurocientífico del Neuroscience Institute in San Diego, California, que en 1983 propuso una teoría sobre la conciencia como un "lugar de trabajo global" (en lugar de que la conciencia esté localizada en único punto del cerebro), afirma en Newscientist estar "emocionado por estos resultados" que, según él, proporcionan la "primera evidencia realmente sólida y directa" de su teoría.

Baars apunta, además, que el hallazgo de esta "marca de conciencia" podría ayudar a buscar señales de conciencia en personas que sufran daño cerebral o en niños y animales con la ayuda de técnicas no invasivas, como el electroencefalograma.