La naturaleza es una máquina de generar patentes: la vida, el sexo, la muerte... En su libro Los grandes inventos de la evolución (Ariel), el bioquímico Nick Lane explora los hitos del mundo natural a la luz de los últimos hallazgos.

Se han escrito millones de páginas sobre los misterios de la vida, pero aún quedan muchos por resolver. Hace sólo 200 años no se sabía nada sobre el origen de los primeros organismos vivos y de qué forma éstos habían sentado las bases de la exuberante riqueza biológica de nuestro planeta. Charles Darwin, con El origen de las especies, fue el primero en vislumbrar la ingeniería evolutiva. Desde entonces, hace ya más de 150 años, hemos rastreado el pasado a través de los fósiles y los genes, dos poderosas máquinas para viajar en el tiempo que, para nuestra desazón, nos dejan con la película a medias.

El panorama está cambiando con técnicas como la genómica comparativa, que permite cotejar ADNs de cientos de especies; y la biología computacional, que identifica estructuras en las proteínas que permenecen inmutables a pesar de los cambios en los genes que las fabrican. Estos y otros avances, caso del análisis isotópico de los fósiles, están permitiendo poner orden en el gran puzzle que es la vida. Quizás nunca se acabe de resolver, pero al menos ya puede ser analizado en detalle.

Eso ha hecho el bioquímico británico Nick Lane en su libro Los diez grandes inventos de la evolución (Ariel, 2009), en donde desgrana los que él considera grandes momentos en la historia de la vida terrestre. A veces, su relato resulta muy distinto al que estábamos acostumbrados. Por ejemplo, según Lane, puede que la vida no emergiera de un caldo orgánico, como conjeturó Darwin, sino al calor de las fumarolas hidrotermales, en los fondos oceánicos. Quizá incluso en esas aguas aparecieron los estímulos necesarios para que se produjera la fotosíntesis, de la que se obtuvo oxígeno, gracias al cual surgieron las células complejas. Y así, paso a paso, se reescribe la evolución.

1. EL ORIGEN DE LA VIDA

Si viajáramos 3.800 millones de años atrás, nos encontraríamos un planeta desgarrado que gira a toda máquina escupiendo borbotones de magma entre sus grietas. El día duraba cinco horas y la atmósfera está cubierta de una niebla espesa sin oxígeno. En estas condiciones tan poco halagüeñas surgió la vida. No se sabe cómo empezó, pero sí que se trató de un affaire químico entre átomos y moléculas que se atraían y repelían. La primera pista del origen de la vida se obtuvo en 1970, cuando se observaron columnas de agua hirviente que brotaban de la falla de las islas Galápagos.

El océano alquimista. Siete años más tarde, una expedición norteamericana descubrió una riqueza animal brutal tras aquellas columnas, así como chimeneas hidrotermales de las que emanaban sulfuros metálicos en ebullición. El agua de mar se filtraba por las fumarolas y se cargaba de minerales y gases, a partir de los que algunas bacterias, capaces de vivir a más de 100 ºC, extraían hidrógeno, lo unían al CO2 y formaban materia orgánica. Así podían prosperar sin luz solar. Quizás, pues, el primer organismo vivo no fue una célula libre formada en una sopa de elementos, como propuso Darwin, sino que se gestó en un laberinto rocoso de células minerales en las entrañas de la Tierra.

2. LA CÉLULA COMPLEJA

Las bacterias y tal vez las arqueas –otros seres unicelulares– fueron las únicas gobernantas del planeta durante 3.000 millones de años. Cuesta entender cómo estos seres simplones o procariotas dieron pie a las células complejas –los eucariotas– que forman los animales y las plantas. Precisamente es el núcleo, donde se almacena el ADN, lo que las distingue de las bacterias. Pero hay más diferencias entre ellas: por ejemplo, las eucariotas son entre 10.000 y 100.000 veces más grandes que las bacterias –la mayor es el huevo de avestruz–, tienen orgánulos –compartimentos con funciones concretas– y son capaces de engullir otras células.

Echar chispas. Las hipótesis más consesuadas sobre el paso de procariota a eucariota apuntan en una dirección: los procesos simbiogenéticos, esto es, el intercambio de material genético entre diferentes bacterias con distintas habilidades. Para el microbiólogo Carl Woese, los eucariotas nacieron por la fusión de arqueas y bacterias. Y para Nick Lane, la clave está en las mitocondrias, orgánulos celulares que tienen su origen en bacterias devoradoras de oxígeno. Las mitocondrias son las centrales energéticas de la célula y no parecen ser el mejor lugar para almacenar genes –¡generan descargas eléctricas!–, aunque tiene los suyos a buen recaudo. Por eso, se cree que las eucariotas inventaron el núcleo, donde guardan celosamente su molécula de la herencia. De este modo, además, quedaba garantizado el suministro de energía celular.

3. EL CÓDIGO GENÉTICO

En 1953, el biofísico británico Francis Crick y su compañero, el biólogo James Watson, hicieron el descubrimiento más importante en la historia de la biología desde la teoría de Darwin: dieron con la estructura de doble hélice del ácido desoxirribonucleico o ADN. El hallazgo fue el acelerante para descifrar cómo funciona la llamada hebra de la vida. Esta sigue un código que establece las normas para traducir la información contenida en un gen y fabricar la proteína respectiva. Se creía que el ADN era el origen del código, pero recientes trabajos apuntan que fue concebido por el ARN, más corto que el ADN y de una sola hebra.

Don ARN. Las instrucciones para el funcionamiento de un organismo están en el ADN celular, que es el portador de los genes. Cuando una célula necesita llevar a cabo una acción, que se resume en la sintesis de una proteína, el ADN copia la secuencia del gen que la codifica en una molécula de ARN mensajero. Este abandona el núcleo y viaja hasta los ribosomas, las fábricas de proteínas. Por otro lado, para que el ADN se copie y pase a la siguiente generación, necesita proteínas específicas. Estas no pueden evolucionar sin ADN y el ADN tampoco puede hacerlo sin ellas. Es el dilema del huevo o la gallina: ¿qué fue primero, el ADN o la proteína? Esta disyuntiva se resolvió en la década de los ochenta, cuando se descubrió que el ARN era capaz de asumir el papel del ADN y el de las proteínas. El hallazgo sugería que el código genético podía haber surgido de la interacción del ARN y las proteínas, sin intermediación de ADN. La siguiente cuestión es evidente: ¿De dónde salió el ARN?

Las últimas teorías en bioquímica apuntan que las chimeneas hidrotermales –posibles testigos del nacimiento de la vida– podrían haber dispuesto las condiciones necesarias para que se formaran los primeros nucleótidos, las piezas que constituyen el ARN y el ADN. Este último, que resistía más las mutaciones, era un almacén de genes mucho más fiable que el ARN. Sólo había que transformar ARN en ADN para iniciar el ciclo de la vida. Para ello se necesitaba una enzima, que es la misma que utilizan los retrovirus modernos para copiar su material genético en la célula huésped y replicarse. Por eso, “puede que la vida comenzara con un ciclo de vida retrovírico”, afirma Lane.

4. LA FOTOSÍNTESIS

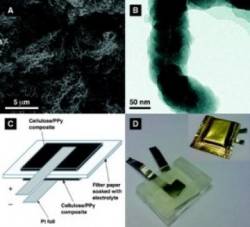

Que nuestro planeta sea verde se lo debemos al pigmento que tiñe las hojas de los vegetales, la clorofila. Este pigmento es imprescindible para que se produzca la fotosíntesis, un proceso que, con ayuda del sol, transforma la materia inorgánica –CO2– en orgánica –glucosa– y libera el oxígeno que hace posible la vida en la Tierra. La clorofila absorbe la radiación solar, que utiliza para romper moléculas de agua y, de paso, liberar electrones de su estructura. Si disparamos unas cuantas de estas partículas negativas sobre el CO2 fijado en las hojas de las plantas, obtenemos glucosa. La extracción de esos electrones tiene lugar en los cloroplastos, estructuras de las células vegetales que contienen la clorofila y otros pigmentos fotosintéticos.

Partiendo el agua. Los antepasados de los cloroplastos fueron las cianobacterias. Hace 3.000 millones de años, estas rompían el agua mediante una única sustancia fotosintética, para obtener energía y alimento. El gen que regulaba la síntesis del pigmento se duplicó y originó dos fotosistemas –centros con moléculas fotosintéticas– que la selección natural fue separando. Las cianobacterias utilizaban uno de esos dos sistemas, pero nunca ambos a la vez. Sin embargo, las plantas y algas actuales emplean dos grupos de clorofilas distintas. ¿Cuándo empezaron a combinarse?

Oxigenados. Según Lane, las cianobacterias se toparon con un problema: en el segundo fotosistema se producía una sobrecarga de electrones que lo inutilizaba. Sus células utilizaban manganeso para protegerse de las radiaciones ultravioletas. Cuando un átomo de manganeso absorbía luz ultravioleta, liberaba un electrón que era engullido por la clorofila en el segundo fotosistema, y el proceso se atascaba. La solución fue que ambos sistemas funcionaran a la vez. Así, los electrones liberados salían del manganeso, atravesaban los dos fotosistemas y llegaban al CO2; se unían a él y producían un desecho valiosísimo para el planeta: el oxígeno.

5. LA VISTA

Los primeros ojos del registro fósil son de hace 540 millones de años, muy próximos a la llamada explosión del Cámbrico, una época en la que repentinamente y sin que los científicos sepan explicar por qué, la Tierra se llenó de una gran variedad de organismos complejos. Por eso, los científicos creen que o bien el invento de la vista provocó este cambio evolutivo, o bien ya existía antes y por alguna razón no fosilizó. Hay más de una forma de fabricar ojos. Los de los trilobites eran de calcita. Los camarones, las vieiras y las langostas emplearon cristales de guanina, mientras que los mamíferos optamos por los cristalinos proteicos. Todos tenían en común un fotorreceptor, la rodopsina.

Los ojos del alga. La rodopsina cumple dos funciones biológicas: posibilita la visión y regula el ritmo circadiano de los seres vivos. Los científicos creen que antaño hubo células fotosensibles que contenían rodopsina. Sus hijas evolucionaron en dos direcciones: unas trazaron el camino de la visión; y las otras, el del control circadiano. Por razones desconocidas, los vertebrados e invertebrados escogieron células diferentes para realizar esas tareas.

¿Pero cuál fue el primer ser vivo con ojos? Posiblemente un alga que utilizaba pigmentos –entre ellos, rodopsina– para registrar la intensidad de la luz. Esos pigmentos también se hallan en las membranas de los cloroplastos, responsables de la fotosíntesis, cuyos antepasados hace mil millones de años eran las cianobacterias. Por eso Lane postula que estas ya debían ser capaces de detectar los cambios lumínicos del entorno.

6. EL SEXO

El origen –y el mantenimiento– del sexo es uno de los mayores galimatías de la biología moderna. A priori, la reproducción asexual es más cómoda: todo el mundo puede generar descendencia partiéndose en dos y no hace falta gastar energía en buscar un partenaire.

Pisotear al compañero. La reproducción sexual es una coctelera en la que se mezclan genes aleatoriamente. Un espermatozoide se une a un óvulo para formar una nueva célula, y a partir de ahí comienzan el proceso de duplicación del ADN y la meiosis, un baile de cromosomas en el que estos se mezclan para generar otros nuevos. Y este es el verdadero meollo de la cuestión, porque, además, hay genes tramposos que intentan a toda costa pasar a la descendencia, aunque para eso tengan que pisotear a los otros. Visto así, no parece que el sexo sea la mejor forma para perpetuarse, aunque, si está presente en casi todos los organismos eucariotas, por algo será. Y es que para estos el celibato es peor, porque conduce inevitablemente a la extinción.

Ya en 1094, el biólogo alemán August Weismann alegó que el sexo beneficia a las poblaciones, pues agrupa combinaciones de genes positivos, que mejoran la progenie; y de negativos, que borran del mapa a sus portadores. Seguramente sucedió así en sus orígenes: un puñado de células comenzó a mezclar sus materiales genéticos en lugar de clonarse, como hacían las bacterias. Aquel feliz accidente otorgaba una enorme ventaja a la descendencia, que empezó a acumular buenas mutaciones.

evolucion-10-47. EL MOVIMIENTO

La posibilidad de moverse de los primeros organismos “ha dictado el paso de la evolución, el ritmo al que genes y especies cambian a lo largo de la historia”, afirma Lane. Al final del pérmico, hace 250 millones de años, aparecieron los músculos, máquinas capaces de transformar la energía química en mecánica. Están formados por bandas regulares de fibras que se contraen o se relajan en función de dos moléculas, la actina y la miosina. También hay una segunda familia de proteínas motoras, las kinesinas, que participan en los movimientos de entes celulares, como el de los cromosomas durante la división celular. Todas ellas –miosinas, actinas y kinesinas–, tienen su antepasado en las bacterias.

Que la fuerza te acompañe. Las bacterias móviles de la actualidad –no todas lo son–, se desplazan deslizándose, contrayéndose o mediante flagelos. Lo que sigue siendo un misterio es cómo desarrolló su motilidad la célula eucariota, si fue a partir de genes que ya estaban en ella o gracias a la cooperación entre células, como sostiene la bióloga Lynn Margulis. Lo que sí se sabe es que el antepasado de los organismos eucariotas era móvil, porque sin la capacidad de producir fuerza para desplazarse se habría extinguido.

8. LA SANGRE CALIENTE

La sangre caliente es un invento bastante reciente que confiere muchas ventajas. Un ave, de sangre caliente, es capaz de generar 10 o 15 veces más calor que una tortuga de tamaño similar, de sangre fría, que necesita ponerse al sol para mantener su temperatura corporal. Una lagartija huye mucho más veloz que un mamífero, pero después del sprint debe detenerse a descansar exhausta durante unas horas.

Calientes y resistentes. Gracias a la respiración anaeróbica, los animales de sangre fría –ectotermos– generan energía muy rápidamente, aunque no pueden mantenerla mucho tiempo debido a su metabolismo lento. En cambio, el rápido metabolismo de los animales de sangre caliente –homeotermos– consume mucho oxígeno y calorías, pero les permite mejorar su rendimiento. Si bien tener sangre caliente supone llevar una vida más corta marcada por el hambre, conlleva recompensas, como energía, resistencia y un cerebro voluminoso.

¿Cuándo se caldeó? Los antepasados de los mamíferos y las aves –de sangre caliente– y de los cocodrilos –de sangre fría– se localizan en el periodo Triásico, que comenzó hace 250 millones de años, muy cerca de la extinción pérmica que acabó con el 95% de las especies.

Según Nick Lane, si no fuera por los hervíboros quizás nunca hubiéramos desarrollado la homeotermia –pocos lagartos actuales comen plantas–. Y puede que esa relación entre la dieta vegetariana y la sangre caliente tenga que ver con el nitrógeno. Los vegetales, al contrario que la carne, son bajos en este compuesto químico, que resulta esencial para que los organismos fabriquen proteínas. Para conseguir la cantidad necesaria de nitrógeno, los hervíboros debían atiborrarse de plantas. Y eso hacían. Pero les generaba un problema: un exceso de carbono, abundante en los vegetales, del que tenían que librarse. ¿Cómo? Quemándolo. Y nada mejor que un metabolismo rápido, que es propio de los animales de sangre caliente, para consumir esos residuos carbónicos.

evolucion-10-19. LA CONSCIENCIA

Antes del primer año, los bebés se reconocen en el espejo. Esta capacidad que llamamos consciencia plantea numerosos interrogantes. El cerebro físico es un producto de la evolución, ¿pero la mente, que es inmaterial, de dónde surgió? Los neurocientíficos distinguen entre dos formas de consciencia estrechamente relacionadas. La primaria tiene que ver con las emociones y las percepciones, y se nutre de la información que llega al cerebro de los sentidos. La consciencia extendida está relacionada con la cultura y la representación abstracta del mundo.

Atlas emocional. Para el neurólogo portugués Antonio Damasio, el cerebro procesa los estímulos que vienen de los sentidos y elabora un mapa neuronal con las emociones. Por ejemplo, ver a un hijo genera una respuesta emocional en el cerebro. “La consciencia es el conocimiento de los objetos del mundo que alteran el yo y cambian esos mapas neuronales”, afirma Lane.

Nuestro cerebro está dotado de una maraña de fibras nerviosas que conectan sus zonas. Los genes dibujan el circuito general, y la experiencia, el cableado de los detalles. Cuando percibimos algo, diferentes regiones del cerebro se activan en sincronía y deben actuar al unísono tanto para captarlo como para revivirlo. Así funciona: la consciencia primaria recoge percepciones y reconstruye el presente, mientras que la extendida une memoria y lenguaje, dota de significado emocional a cada percepción y le añade pasado y futuro.

10. LA MUERTE

La muerte tiene beneficios evolutivos. Hace 3.000 millones de años, las cianobacterias que poblaban la Tierra contenían una maquinaria suicida de enzimas que desmantelaban la célula desde dentro. Esta decisión de quitarse de en medio o apoptosis puede tener su origen en la especialización celular. Las poblaciones de cianobacterias estaban formadas por trillones de células que empezaron a realizar funciones distintas para adaptarse al entorno. Las suicidas apoyaron con su muerte a las de la línea principal, que se perpetuó. Del mismo modo, para que se formen las manos en el embrión humano, las células que unen los dedos con una membrana tienen que inmolarse.

Viejas dudas. Sólo la muerte hace posible la vida multicelular, pero una cosa es morir y otra hacerse viejos. En los 50 se creía que envejecíamos a causa de los radicales libres, que atacaban el ADN y las proteínas, pero ahora se sabe que estas moléculas optimizan la respiración celular. La alimentación tiene mucho que ver con la longevidad. Estudios con ratas han demostrado que una restricción calórica alarga la vida y hace que padezcan menos enfermedades asociadas al envejecimiento. Eso sí, el castigo por vivir más años es la infertilidad.