Su capacidad de desarrollar actividades cognitivas y emotivas obligará a decidir qué posición ocuparán en la sociedad futura

Su capacidad de desarrollar actividades cognitivas y emotivas obligará a decidir qué posición ocuparán en la sociedad futura

Un robot social es aquel que interactúa y se comunica con las personas (de forma sencilla y agradable) siguiendo comportamientos, patrones y normas sociales. Para eso –además de tener apariencia humanoide– se necesita que disponga de habilidades que se ubican dentro del dominio de la llamada inteligencia social. La mayoría de los robots actuales funcionan relativamente bien en entornos controlados, como –por ejemplo– los laboratorios, pero surgen problemas cuando operan en entornos más reales, tales como oficinas, casas o fábricas. No obstante, en poco tiempo el robot hogareño se acoplará a la vida del Hombre como alguna vez lo hizo el teléfono, la televisión, el automóvil y la computadora personal. Ahora bien, si un robot puede desarrollar tanto actividades cognitivas (razonamiento) como afectivas (emociones), habría que empezar a pensar seriamente sobre qué posición ocupa dentro de una sociedad.Se puede definir al “robot inteligente autónomo” como un sistema compuesto por un controlador electrónico acoplado a un cuerpo mecánico, y con ciertas características de autonomía, fiabilidad, movilidad y versatilidad. De este modo, esta máquina necesita de adecuados sistemas sensoriales (para percibir el entorno en donde se desenvuelve), de una precisa estructura mecánica adaptable (a fin de disponer de una cierta destreza física de locomoción y manipulación), de complejos sistemas efectores (para ejecutar las tareas asignadas) y de sofisticados sistemas de control (para llevar a cabo acciones correctivas cuando sea necesario) [Moriello, 2005, p. 172].

Es importante tener presente que la función técnica de los robots no es reemplazar al ser humano, sino aliviarlo de todas aquellas tareas consideradas repetitivas, rutinarias, monótonas, aburridas, arduas, tediosas, fatigosas, insalubres, peligrosas y desagradables. Los autómatas deberían coexistir y cooperar con las personas.

Taxonomía

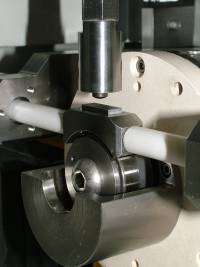

Una clasificación de los robots inteligentes autónomos podría ser en zoomórficos, humanoides, híbridos y polimórficos [Moriello, 2005, p. 138/9]. Los robots zoomórficos se distinguen fundamentalmente porque sus sistemas de locomoción imitan a la de algunas criaturas; por ejemplo, serpientes, cuadrúpedos o arácnidos. Los humanoides (androides o ginoides, según su versión masculina o femenina, respectivamente) podrían considerarse un caso particular del robot zoomórfico en el que el sistema de translación es bípedo, pero se caracterizan principalmente por tratar de reproducir –en mayor o menor medida– la forma del ser humano y sus movimientos.

Bajo la denominación de híbridos se agrupa a aquellos robots que combinan las características de los demás tipos descriptos anteriormente (por ejemplo, un brazo robótico montado sobre una plataforma móvil con ruedas). Por último, los robots reconfigurables o polimórficos tienen la particularidad de que pueden “reconfigurarse” a sí mismos, adaptando su estructura para realizar cada tarea específica. Consisten en una serie de unidades articuladas que pueden unirse en cadenas extensibles, lo cual les permite una amplia gama de posibilidades: caminar, serpentear, nadar o incluso volar. Una vez terminada una labor, la estructura se puede auto-reconfigurar para ejecutar otros trabajos diferentes.

Otra clasificación de los robots inteligentes autónomos podría ser en aéreos, acuáticos y terrestres. Dentro de esta última, se los podrían subclasificar, a su vez, en robots con ruedas y con patas: dos (bípedos), cuatro (cuadrúpedos), seis (hexápodos) y ocho (octópedos).

Robots humanoides

Un robot humanoide es aquel que no sólo tiene la apariencia, sino que también ejecuta movimientos que se asemejan al de un ser humano. También es fundamental la habilidad de interacción social, para lo cual el robot necesita contar con un modelo cognitivo-afectivo del ser humano y de capacidades de comunicación, comprensión y aprendizaje [Adams et al, 2000].

Existen fundamentalmente tres razones para adoptar la forma humanoide: una “filosófica”, otra “psicológica” y, la última, “pragmática” [Moriello, 2005, p. 180/1].

En primer lugar, algunos filósofos cognitivos sostienen que la forma corporal es crítica para el ser humano (para sus pensamientos, sentimientos, conocimientos y lenguaje), ya que organiza y unifica la experiencia vivenciada en diferentes niveles de complejidad. En efecto, el Hombre piensa y habla en términos de su cuerpo; usa su modelo corporal como referencia, como eje central para construir su mundo. Además, algunos neurólogos afirman que el sentido del mundo, de las cosas e –incluso– de la propia identidad surge de la actividad permanente del cuerpo insertado en un entorno específico [Haselager y Gonzalez, 2003].

En consecuencia, si se intenta construir un robot con inteligencia similar a la del Hombre, necesariamente debe poseer un cuerpo lo más parecido al de éste. Sin embargo, y puesto que es harto difícil lograr construir una aproximación genuina, existe el peligro de que se imite sólo lo superficial, pero que se pierda totalmente sus aspectos más profundos.

En segundo lugar, y para que el robot gane experiencia, necesita un gran número de interacciones con los seres humanos. Si el robot tiene una forma humanoide, sería más fácil y natural interactuar con él, ya que las personas le atribuirían no sólo características vivientes sino incluso humanas (las personas están acostumbradas a ciertas reacciones y formas del lenguaje corporal cuando hablan con otras).

Es decir, le adjudicaría estados mentales, pero que tienen poca o ninguna referencia con respecto a la competencias reales del robot [Duffy, 2002]. Esto ayudaría a dichas personas a racionalizar la situación, basándose sobre la observación de las conductas dentro de un dado entorno. El mejor modo de superar el miedo que la humanidad siente ante la máquina inteligente consiste en darles una forma lo más familiar posible. A fin de lograr una adecuada interacción, se debe hacer hincapié sobre algunos temas importantes; por ejemplo, detectar caras e interpretar los gestos faciales, establecer un contacto visual y seguir la mirada de las personas, distinguir las voces humanas de otros sonidos, respetar el espacio personal, etc. [Brooks, 2002].

En tercer lugar, está la ventaja de que utilizarían toda la gama de instalaciones, espacios y servicios, así como aparatos, herramientas y utensilios tecnológicos concebidos para las personas. En suma, podrían participar del “mundo humano”. Después de todo, el homo sapiens ha modificado su entorno de tal manera de hacerlo confortable únicamente para satisfacer las necesidades de un ser con un torso, un par de piernas y brazos, y una cabeza encima de los hombros.

Robots hogareños

La mayoría de los robots funcionan relativamente bien en entornos controlados, como –por ejemplo– los laboratorios, pero surgen problemas cuando operan en entornos más reales, tales como oficinas, casas o fábricas [Vilarroya, 2006, p. 148]. No obstante, muchos están convencidos de que, en poco tiempo más, el robot hogareño se acoplará a la vida del Hombre como alguna vez lo hizo el teléfono, la televisión, el automóvil y la computadora personal.

Hay varios factores importantes para el éxito de los robots hogareños [Moravec, 2000] [Fritz, 2007]. En primer lugar, que tenga un precio razonable, preferiblemente más barato que un automóvil de gama media. En segundo lugar, que sea capaz de moverse y operar –de modo confiable y seguro– dentro del hogar y que el usuario no se vea obligado a llamar al especialista cada vez que ponga en marcha el robot o cambie su rutina.

En tercer lugar, y a fin de no causar temor, debería tener un tamaño y un peso moderados: tal vez el de un adolescente normal de 12 años de edad sería lo adecuado. En cuarto lugar, debería trabajar fiablemente durante un tiempo prudencial (al menos durante medio año).

Por último, debería tener la inteligencia apenas necesaria para limpiar, encerar, lavar, planchar, transportar objetos alrededor de la casa, sacar la basura, utilizar los electrodomésticos del hogar, reconocer a las personas, sostener conversaciones simples y atender visitas. Esto incluye la habilidad para resolver los pequeños problemas cotidianos que los humanos no tienen ni siquiera que pensar (mantenimiento del equilibrio, navegación adecuada, control de la presión manual, coordinación ojo-brazo-mano, etc.) [Balkenius, 2003].

Para ayudar a la gente en sus numerosos quehaceres, no es obligatorio que el robot tenga forma humana: el automóvil no copia las cuatro patas de los animales, ni el avión imita el vuelo de las aves. ¿Se necesita la forma humana para abrir puertas, cuando éstas pueden ser automáticas? ¿Es necesario un androide para ejecutar el trabajo de un mensajero o el de una aspiradora, cuando un robot equipado con ruedas puede realizar esas mismas tareas con más rapidez y con menos consumo de energía…, además de ser mucho más barato? El robot humanoide parece tener pocas ventajas sobre los robots diseñados para tareas específicas; sin embargo, son mucho más aptos para fomentar la interacción con las personas.

Robots sociales

Un robot social es aquel que interactúa y se comunica con las personas (de forma sencilla y agradable) siguiendo comportamientos, patrones y normas sociales. Para eso –además de tener apariencia humanoide– se necesita que disponga de habilidades que se ubican dentro del dominio de la llamada inteligencia social. Se debe tener en cuenta que la socialización con las personas es un tema difícil, ya que los robots y los humanos no comparten un lenguaje común ni perciben el mundo de la misma forma.

También es importante que el robot exhiba una cierta “personalidad” distintiva. Hay varias razones para creer que si un robot tuviera una personalidad convincente, la gente estaría más dispuesta a interactuar y establecer algún tipo de relación con él. En particular, la personalidad del robot puede proporcionar una realimentación útil, ofreciendo a los usuarios una manera de modelar y entender su conducta [Fong, Nourbakhsh y Dautenhahn, 2003]. De esta manera, el robot podría reconocer el estado de ánimo del usuario (por el tono de su voz) e, incluso, intentar modificarlo si lo considera necesario.

Otras tareas menos llamativas, pero muy útiles, serían la de acompañante: encontrar y reproducir canciones, grabar programas de televisión, escribir y enviar mensajes de textos y/o correos electrónicos, tomar fotografías, dar la hora, etc. Incluso ayudar a las personas mayores y/o con capacidades disminuidas, a las cuales podrían alimentar, recordarles la toma de medicamentos, recopilarles información diversa (noticias, espectáculos, artículos, direcciones, teléfonos), etc.

A fin de interactuar de manera adecuada, los robots sociales necesitarían básicamente ser capaces de comunicarse con las personas manteniendo diálogos de alto nivel. Para eso, deberían cumplir con una serie de requisitos. Necesitarían ser capaces de seguir visualmente los movimientos del interlocutor (cara, ojo, cuerpo, brazos, manos). También deberían poder reconocer e interpretar el habla humana, lo cual incluye el discurso afectivo, las órdenes discretas y el lenguaje natural.

De igual modo, necesitarían sintetizar la voz humana y reproducirla sin problemas, idealmente con cierta modulación (no con el clásico tinte robótico). Asimismo, deberían tener la capacidad de reconocer las expresiones faciales, los gestos y las acciones humanas y disponer de una cierta capacidad expresiva. Esta última consiste fundamentalmente en la posesión de un rostro, con componentes faciales primarios como ojos, párpados, cejas, mejillas, labios, mandíbula y frente. Finalmente, deberían poder interpretar la conducta social de las personas a través de la construcción de elaborados modelos cognitivos-afectivos.

Algunos dilemas

Es fácil notar que cualquier cosa que pueda hacer un robot no es propia para un ser humano. Es decir, si una persona hace el trabajo que puede hacer un robot, se está desaprovechando muchas de sus capacidades y habilidades. No obstante, ¿qué sucederá en un futuro mediano? Si los robots se vuelven cada vez más complejos y versátiles, ¿no desplazarán a los humanos de sus ocupaciones, convirtiéndolos en algo obsoleto?

Si un robot puede desarrollar tanto actividades cognitivas (razonamiento) como afectivas (emociones), habría que empezar a pensar seriamente sobre qué posición ocupa dentro de una sociedad. De acuerdo con las actuales leyes vigentes, los robots son simplemente una propiedad inanimada sin derechos ni deberes; no son personas legales. ¿Uno lo podría tratar como se le antojase?, o ¿tendrían “pensamientos” y “sentimientos”, con lo cual sería reprochable tratarlos de ciertas maneras? El propietario, ¿tendría derecho a destruir su programación inteligente? ¿Se podría considerar como un asesinato? Por otra parte, el reemplazar un robot –ya obsoleto y/o pasado de moda– por un modelo más nuevo y tirarlo como “chatarra”, como se hace con un automóvil o cualquier electrodoméstico viejo, ¿no sería moralmente reprochable? En las ciudades, ¿es posible que emergieran legiones de anticuados robots “sin propietarios”?, ¿serían ilegales o indocumentados?

Mucho antes de construirlos, se debería tener definido si no es una crueldad producir en masa androides sintientes y pensantes y luego destruirlos en enormes “campos de exterminio”. Es probable que, con el tiempo, los robots demanden la igualdad de “derechos legales”. Pero, ¿qué tipo se les debería otorgar y/o negar? ¿Cuál será el lugar que los robots ocupen dentro de la sociedad? ¿Formarán su propia y particular sociedad?, ¿con sus propios gobernantes?, ¿quiénes tendrán derecho a “votar”?

Por último, y a medida que los robots se vuelvan más y más complejos, es probable que necesiten modelos (físicos, biológicos, psicológicos, sociales) más reales de las personas en general. Sin embargo, ¿podría aceptarse la modelación detallada del usuario (sus gustos, sus inclinaciones, sus placeres, sus secretos) tanto sea a partir de equipos de programadores-psicólogos como a partir del propio aprendizaje del robot?, ¿no constituiría esto una violación a la intimidad del usuario? Y de aceptarse, ¿el robot debería ser capaz de reconocer cuándo la persona está actuando de forma errática y/o equivocada y tomar las medidas correctivas del caso? [Fong, Nourbakhsh y Dautenhahn, 2003].

Bibliografía

1. Adams, Bryan; Breazeal, Cynthia; Brooks, Rodney y Scassellati, Brian, Humanoid Robots: A New Kind of Tool IEEE Intelligent Systems (julio/agosto, 2000), vol. 15, N° 4, p. 25-31.

2. Balkenius, Christian (2003): From Isolated Components to Cognitive Systems ERCIM News (abril), N° 53. Tema Especial: Cognitive Systems.

3. Brooks, Rodney (1998): Prospects for Human Level Intelligence for Humanoid Robots. MIT, julio, Laboratorio de Inteligencia Artificial.

4. Duffy, Brian (2002): Anthropomorphism and Robotics. The Society for the Study of Artificial Intelligence and the Simulation of Behaviour (AISB 2002). 3-5 Abril.

5. Fong, Terrence; Nourbakhsh, Illah y Dautenhahn, Kerstin (2003): A survey of socially interactive robots. Robotics and Autonomous Systems, vol. 42, N° 3-4, 2003, 143-166.

6. Fritz, Walter (2007): Sistemas Inteligentes y sus Sociedades. Última actualización.

.jpg)