Podría ser el primer órgano artificial completamente funcional

Un equipo de investigadores estadounidenses ha conseguido crear un “ovario artificial” en el que se pueden desarrollar los ovocitos (células germinales femeninas) hasta convertirse en óvulos maduros, siguiendo un proceso similar al de los ovarios orgánicos de las mujeres. Estos resultados podrían suponer la creación del primer órgano artificial completamente funcional, afirman los científicos. El ovario artificial servirá para comprender mejor la fertilidad femenina y para preservar la fertilidad de mujeres sometidas a ciertos tratamientos, como la quimioterapia.

Investigadores de la Universidad de Brown y del Women & Infants Hospital of Rhode Island, en Estados Unidos, han conseguido crear un “ovario artificial” en el que se pueden desarrollar los ovocitos (células germinales femeninas) hasta convertirse en óvulos maduros, de la misma forma que estas células maduran en los ovarios orgánicos.

Este logro ayudará a comprender mejor la fertilidad femenina, y también a preservar la fertilidad de aquellas mujeres sometidas a ciertos tratamientos que afectan a la fertilidad, como la quimioterapia.

Actualmente, los investigadores ya están usando el ovario de laboratorio para madurar óvulos humanos, según publica la Universidad de Brown en un comunicado.

Laboratorio viviente

Una de las autoras de la investigación, la directora de la Sección de endocrinología reproductiva e infertilidad del Women & Infants Hospital, Sandra Carson, explica que: “un ovario está compuesto por tres tipos principales de células, y ésta es la primera vez que se crea una estructura tridimensional de tejidos con tres líneas de células”.

Según la investigadora, el ovario artificial no sólo será un auténtico “laboratorio viviente” para el estudio de cuestiones fundamentales sobre cómo funciona un ovario sano, sino que también servirá como plataforma de análisis de cómo ciertos problemas, como la exposición a toxinas u otros productos químicos, pueden afectar a la maduración y a la salud de los óvulos.

Por otro lado, en el aspecto clínico, el ovario artificial podría servir para preservar la fertilidad de mujeres que estén sometidas a tratamientos de quimioterapia.

Esto se haría de la siguiente forma: los óvulos aún inmaduros serían extraídos del organismo y congelados antes del inicio de la quimioterapia o de la radiación, para hacerlos madurar posteriormente fuera de la paciente en el ovario artificial, explican los científicos.

Creación del ovario

Lo que ha permitido que un ovario artificial se convierta en tejido funcional, en lugar de ser sólo un mero cultivo de células, ha sido la combinación de tres tipos de células en una estructura similar al de los ovarios de las mujeres.

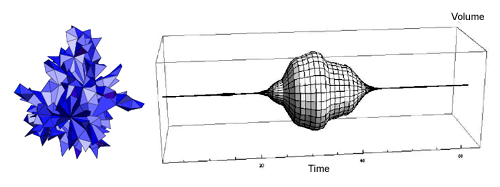

Dicha estructura fue generada en el laboratorio de un investigador llamado Jeffrey Morgan. Morgan creó unos platos de Petri (cilindros que usan los biólogos para el cultivo de células) tridimensionales, formados por un gel moldeable de un polisacárido denominado agarosa.

La agarosa es un producto natural que forma una matriz inerte y no tóxica y se utiliza en gran cantidad de técnicas de biología molecular, bioquímica y biología celular. El entorno tridimensional creado por Morgan propicia que las células se acoplen dando lugar a formas específicas.

En el caso del ovario artificial, los investigadores formaron panales de células de la teca interna (que son células productoras de hormonas que se encuentran en los ovarios), que habían sido donadas por pacientes del hospital en edad reproductiva (de entre 25 y 46 años).

Después de que las células de la teca crecieran dentro de la estructura con forma de panal, se insertaron en ésta aglomeraciones esféricas de un segundo tipo de células, denominadas células de la granulosa. Dichas células se colocaron en los agujeros de los panales junto con óvulos humanos no maduros, llamados ovocitos.

En unos días, las células de la teca se acoplaron con las células de la granulosa y los ovocitos, siguiendo un proceso similar al que se da en los ovarios reales.

Posible primer órgano artificial funcional

La gran prueba final consistió en comprobar si la estructura formada podía funcionar completamente como un ovario, dando lugar a óvulos maduros. En experimentos realizados, se constató que, efectivamente, así era.

Según publican los investigadores en la revista especializada Journal of Assisted Reproduction and Genetics, este logro “representa el primer éxito en el uso de ingeniería de tejidos 3-D para la maduración de ovocitos in vitro".

Los resultados obtenidos por los investigadores abren la posibilidad de que se haya conseguido crear el primer órgano artificial completamente funcional. Hasta ahora, se habían dado otros pasos en el desarrollo de órganos artificiales con células, pero no se habían logrado resultados tan avanzados.

Por ejemplo, científicos del Weill Cornell Medical College, de Estados Unidos, anunciaron recientemente el desarrollo de un nuevo y eficiente método para crear células endoteliales, que son las células encargadas de crear los vasos sanguíneos y que recubren el interior de éstos.

Por otro lado, investigadores del MIT (el Instituto Técnico de Massachusets) publicaban el pasado mes de mayo que habían conseguido replicar tejido humano en laboratorio ensamblando unas células con otras. De esta forma, los científicos lograron crear vasos sanguíneos siguiendo una técnica, la «micro-masonry», que se cree que en el futuro podría servir para desarrollar órganos completos.