Ingenieros estadounidenses y portugueses están trabajando juntos en el desarrollo de un nuevo dispositivo que ya está demostrando ser mucho más eficiente que otros a la hora de convertir la energía mecánica que generan las olas del mar en energía eléctrica. El dispositivo, al que han llamado OWC, consiste en una cámara con una abertura y una conexión a una turbina. Según sus creadores, el OWC aprovecha la compresión del aire dentro de la cámara cuando las olas entran en ella para que la turbina funcione y produzca electricidad. Tres de estos dispositivos serán instalados en un rompeolas en la desembocadura del río Duero en Oporto, Portugal. Generarán 750 Megavatios que darán luz a unos 750 hogares.

TENDENCIAS CIENTÍFICAS

Ingenieros del MIT y del Instituto Técnico Superior de la Universidad Técnica de Lisboa están diseñando un dispositivo que captará significativamente más energía de las olas oceánicas que los sistemas existentes. Esa energía se usará para alimentar una turbina. Por el momento, han construido uno de estos dispositivos a escala.

La energía a partir de las olas es una fuente de energía renovable con un enorme potencial. En algunos sitios, como en el noroeste de los Estados Unidos, la costa oeste de Escocia o el extremo sur de Sudamérica, África o Australia, un dispositivo para extraer energía de las olas podría, teóricamente, generar entre 100 y 200 megavatios de electricidad por kilómetro de costa.

El problema es diseñar un sistema que pueda resistir el poder de corrosión del mar, que esté siempre operativo, que gestione las variaciones estacionales de la intensidad de las olas o que continúe operando incluso en condiciones meteorológicas complicadas, como durante una tormenta.

El profesor Chiang Mei , del Departamento de Ingeniería Civil y Medio Ambiental del MIT, empezó a creer en la energía eólica desde finales de los años 70, durante la crisis energética. Tras la reciente escalada de los precios del petróleo, este profesor ha renovado su interés por aprovechar esta fuente energética.

Según un comunicado del MIT, el profesor Mei y sus colegas han desarrollado unas simulaciones numéricas capaces de predecir las fuerzas de las olas en un dispositivo dado. Estas simulaciones permiten tomar las mejores decisiones para maximizar la captación de energía y proporcionar datos para buscar las maneras más eficientes de convertir la energía mecánica en energía eléctrica.

Portugal, una potencia

Uno de los países con un mejor nivel de investigación y desarrollo en estas técnicas es Portugal. Durante los últimos tres años, Mei ha estado trabajando codo con codo con los profesores Antonio Falcao, Antonio Sarmento y Luis Gato, de la Universidad Técnica de Lisboa. Han estado diseñando una versión piloto a escala de una instalación llamada columna de agua oscilante (OWC, en inglés).

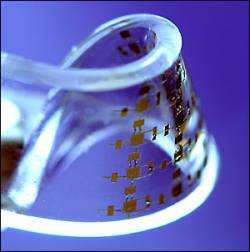

Instalada en o sobre la propia costa, una OWC consiste en una cámara con una abertura. Al mismo tiempo que las olas entran y salen, el nivel del agua dentro de la cámara sube y baja. El movimiento de la superficie del agua obliga al aire a comprimirse sobre ella y, posteriormente, a fluir hacia la abertura que, a su vez, lo dirige hacia la turbina que, en última instancia, convierte la energía mecánica en electricidad.

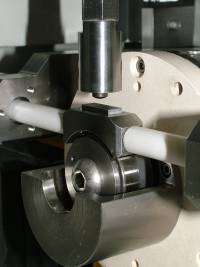

La turbina está diseñada de tal manera que las palas siempre rotan en la misma dirección, sin que en ello influya un cambio de dirección de la corriente de aire debido al movimiento de entrada y salida de las olas.

El plan de los ingenieros portugueses es integrar la planta OWC en la cabecera de un rompeolas, en la desembocadura del río Duero, en Oporto, al norte de Portugal. En última instancia, la instalación incluirá tres OWCs que generarán 750 kilovatios, suficiente para abastecer de energía 750 hogares. Además, permitirá calmar las aguas en esta área y reducir la erosión local.

Compresión de aire

El reto es diseñar un dispositivo que funcione eficientemente en un espectro amplio de frecuencias de olas. La clave para conseguirlo es la compresión del aire dentro de la cámara OWC. Esta capacidad de compresión no puede ser cambiada, pero el impacto en la elevación del agua en la cámara sí que puedo serlo simplemente cambiando el tamaño de ésta.

Las simulaciones han puesto de manifiesto que, usando una cámara grande, es posible captar más energía en una ola determinada. "Hemos descubierto que es posible optimizar la eficiencia de la OWC haciendo uso de la compresión del aire, algo que, en principio, no es obvio", comenta Mei.

Mei está actualmente trabajando en otros dispositivos parecidos. En concreto está estudiando otras geometrías para el mismo fin. El entusiasmo de Mei por este tipo de energía sigue intacto, pero no deja de ser realista respecto a su nivel de desarrollo tecnológico y respecto a sus costes. Aunque éstos se han reducido mucho en los últimos años, estamos ante un tipo de energía que no podrá ser explotada comercialmente hasta dentro de varias décadas.

"Dado el futuro de las fuentes de energía convencionales, necesitamos investigar más en las energías alternativas", comenta. "Por el momento, la energía eólica y solar están en el punto de mira porque su desarrollo empezó antes. La energía extraída de las olas tiene mucho potencial, pero es una disciplina de la ingeniería relativamente joven que necesita más investigación".

.jpg)